- 动态与公告

- 产品简介

- 购买指南

- 快速入门

- 操作指南

- CKafka 连接器

- 最佳实践

- 故障处理

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- DataHub APIs

- ACL APIs

- Topic APIs

- BatchModifyGroupOffsets

- BatchModifyTopicAttributes

- CreateConsumer

- CreateDatahubTopic

- CreatePartition

- CreateTopic

- CreateTopicIpWhiteList

- DeleteTopic

- DeleteTopicIpWhiteList

- DescribeDatahubTopic

- DescribeTopic

- DescribeTopicAttributes

- DescribeTopicDetail

- DescribeTopicProduceConnection

- DescribeTopicSubscribeGroup

- FetchMessageByOffset

- FetchMessageListByOffset

- ModifyDatahubTopic

- ModifyTopicAttributes

- DescribeTopicSyncReplica

- Instance APIs

- Route APIs

- Other APIs

- Data Types

- Error Codes

- SDK 文档

- 通用参考

- 常见问题

- 服务等级协议

- 联系我们

- 词汇表

- 动态与公告

- 产品简介

- 购买指南

- 快速入门

- 操作指南

- CKafka 连接器

- 最佳实践

- 故障处理

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- DataHub APIs

- ACL APIs

- Topic APIs

- BatchModifyGroupOffsets

- BatchModifyTopicAttributes

- CreateConsumer

- CreateDatahubTopic

- CreatePartition

- CreateTopic

- CreateTopicIpWhiteList

- DeleteTopic

- DeleteTopicIpWhiteList

- DescribeDatahubTopic

- DescribeTopic

- DescribeTopicAttributes

- DescribeTopicDetail

- DescribeTopicProduceConnection

- DescribeTopicSubscribeGroup

- FetchMessageByOffset

- FetchMessageListByOffset

- ModifyDatahubTopic

- ModifyTopicAttributes

- DescribeTopicSyncReplica

- Instance APIs

- Route APIs

- Other APIs

- Data Types

- Error Codes

- SDK 文档

- 通用参考

- 常见问题

- 服务等级协议

- 联系我们

- 词汇表

操作场景

Datahub 提供数据流出能力,您可以将 CKafka 数据分发至 COS 以便于对数据进行分析与下载等操作。

前提条件

该功能目前依赖对象存储(COS)产品,使用时需开通相关产品功能。

操作步骤

创建任务

1. 登录 CKafka 控制台 。

2. 在左侧导航栏单击数据流出,选择好地域后,单击新建任务。

3. 目标类型选择对象存储(COS),单击下一步。

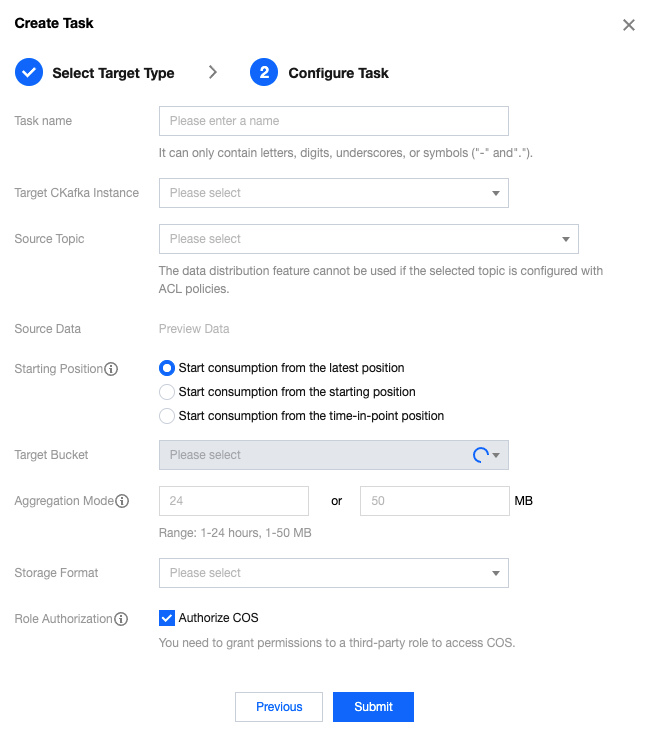

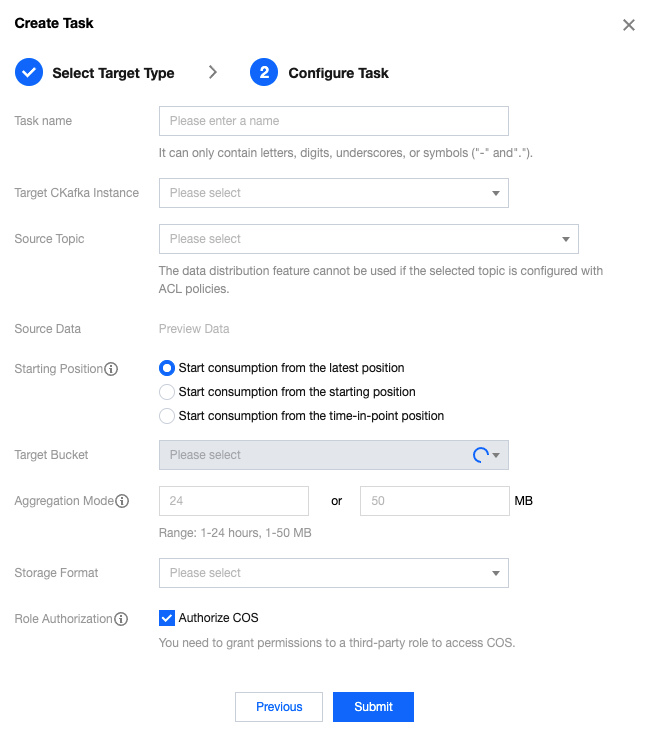

4. 在任务设置页面,填写任务详情。

任务名称:只能包含字母、数字、下划线、"-"、"."。

CKafka 实例:选择数据源 CKafka。

源 Topic:选择源 Topic,一条数据流出任务最多支持选择5个源 Topic。

起始位置:转储时历史消息的处理方式,topic offset 设置。

目标存储桶:对不同的 Topic,选取相应的 COS 中 Bucket,则请求消息会自动在 Bucket 下创建

instance-id/topic-id/date/timestamp 为名称的文件路径进行存储。聚合方式:请至少填写一种聚合方式,文件将根据指定方式聚合进入 COS 存储桶。如果指定了两种聚合方式,则会同时生效。例:指定每1h或1GB聚合一次,若在1h之前达到1GB,则文件会聚合,同时在1h时也会聚合一次。

注意:

当单条消息大小大于设置的聚合文件大小时,消息可能会被截断。

存储格式:支持 csv 和 json 格式。

角色授权:使用对象存储(COS)产品功能,您需要授予一个第三方角色代替您执行访问相关产品权限。

5. 单击提交,完成任务创建。

查看监控

1. 登录 CKafka 控制台 。

2. 在左侧导航栏单击数据流出,单击目标任务的 ID,进入任务基本信息页面。

3. 在任务详情页顶部,单击监控,选择要查看资源,设置好时间范围,可以查看对应的监控数据。

产品限制和费用计算

转储速度与 CKafka 实例峰值带宽上限有关,如出现消费速度过慢,请检查 CKafka 实例的峰值带宽或增加 CKafka partition 数。

转储速度与 CKafka 单个文件大小相关,如超过该500M,会自动分包上传。

当前仅支持和 CKafka 实例同个地域的 COS 进行消息存储,为保证延时,不支持跨地域存储。

使用 COS 消息转储,文件内容是 CKafka 消息里的 value 用 utf-8 String 序列化拼接而成,暂不支持二进制的数据格式。

开启转 COS 的操作账号必须对目标 COS Bucket 具备写权限。

使用 COS 消息转储必须至少拥有一个 VPC 网络环境,如在创建时选择基础网络请参见 路由接入方式 绑定 VPC 网络。

是

是

否

否

本页内容是否解决了您的问题?