- 动态与公告

- 产品简介

- 购买指南

- 快速入门

- 访问管理

- 准备工作

- 数据迁移

- 数据同步

- 数据订阅(Kafka 版)

- 数据迁移(旧版)

- 数据订阅(旧版)

- 前置校验不通过处理方法

- 检查项汇总

- MySQL/MariaDB/Percona/TDSQL-CMySQL/TDSQLMySQL校验项

- MongoDB 校验项

- PostgreSQL 校验项

- TDSQL PostgreSQL

- Redis/Tendis 校验项

- SQL Server 校验项

- 连接 DB 检查

- 源库存在性检查

- 目的库存在性检查

- 周边检查

- 迁移网络检查

- 版本检查

- 源实例权限检查

- 帐号冲突检查

- 部分实例参数检查

- 源实例参数检查

- 源实例是否为从机

- 参数配置冲突检查

- 目标实例内容冲突检查

- 目标实例空间检查

- 目的端负载校验

- 本地磁盘空间检查

- Binlog 参数检查

- Oplog 校验

- 外键依赖检查

- 视图检查

- 高级对象检查

- 增量迁移预置条件检查

- 插件兼容性检查

- 源端 Balancer 校验

- 源端节点角色校验

- 片建校验

- 警告项检查

- 二级分区表检查

- 待迁移的表是否有主键检查

- 待迁移表的 DDL 检查

- 源实例迁移库和目标实例系统库冲突检查

- 目标实例和源实例表结构检查

- 表是否是 InnoDB 表检查

- 视图之间以及视图和表之间的互相依赖检查

- 约束检查

- 割接说明

- 监控与告警

- 运维管理

- DTS-DBbridge

- 最佳实践

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- (NewDTS) Data Migration APIs

- DescribeMigrationJobs

- DescribeMigrationDetail

- CreateMigrationService

- ModifyMigrationJob

- CreateMigrateCheckJob

- DescribeMigrationCheckJob

- SkipCheckItem

- StartMigrateJob

- StopMigrateJob

- ResumeMigrateJob

- RecoverMigrateJob

- ModifyMigrateName

- ModifyMigrateJobSpec

- IsolateMigrateJob

- DestroyMigrateJob

- DescribeMigrateDBInstances

- CompleteMigrateJob

- PauseMigrateJob

- ContinueMigrateJob

- Data Sync APIs

- ModifySyncJobConfig

- CreateModifyCheckSyncJob

- DescribeModifyCheckSyncJobResult

- StartModifySyncJob

- DescribeSyncJobs

- CreateSyncJob

- ConfigureSyncJob

- CreateCheckSyncJob

- SkipSyncCheckItem

- DescribeCheckSyncJobResult

- StartSyncJob

- StopSyncJob

- ResumeSyncJob

- ResizeSyncJob

- RecoverSyncJob

- IsolateSyncJob

- DestroySyncJob

- PauseSyncJob

- ContinueSyncJob

- Data Consistency Check APIs

- Data Types

- Error Codes

- DTS API 2018-03-30

- SDK 文档

- 常见问题

- 错误处理(NewDTS)

- 错误处理(旧版)

- 相关协议

- 动态与公告

- 产品简介

- 购买指南

- 快速入门

- 访问管理

- 准备工作

- 数据迁移

- 数据同步

- 数据订阅(Kafka 版)

- 数据迁移(旧版)

- 数据订阅(旧版)

- 前置校验不通过处理方法

- 检查项汇总

- MySQL/MariaDB/Percona/TDSQL-CMySQL/TDSQLMySQL校验项

- MongoDB 校验项

- PostgreSQL 校验项

- TDSQL PostgreSQL

- Redis/Tendis 校验项

- SQL Server 校验项

- 连接 DB 检查

- 源库存在性检查

- 目的库存在性检查

- 周边检查

- 迁移网络检查

- 版本检查

- 源实例权限检查

- 帐号冲突检查

- 部分实例参数检查

- 源实例参数检查

- 源实例是否为从机

- 参数配置冲突检查

- 目标实例内容冲突检查

- 目标实例空间检查

- 目的端负载校验

- 本地磁盘空间检查

- Binlog 参数检查

- Oplog 校验

- 外键依赖检查

- 视图检查

- 高级对象检查

- 增量迁移预置条件检查

- 插件兼容性检查

- 源端 Balancer 校验

- 源端节点角色校验

- 片建校验

- 警告项检查

- 二级分区表检查

- 待迁移的表是否有主键检查

- 待迁移表的 DDL 检查

- 源实例迁移库和目标实例系统库冲突检查

- 目标实例和源实例表结构检查

- 表是否是 InnoDB 表检查

- 视图之间以及视图和表之间的互相依赖检查

- 约束检查

- 割接说明

- 监控与告警

- 运维管理

- DTS-DBbridge

- 最佳实践

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- (NewDTS) Data Migration APIs

- DescribeMigrationJobs

- DescribeMigrationDetail

- CreateMigrationService

- ModifyMigrationJob

- CreateMigrateCheckJob

- DescribeMigrationCheckJob

- SkipCheckItem

- StartMigrateJob

- StopMigrateJob

- ResumeMigrateJob

- RecoverMigrateJob

- ModifyMigrateName

- ModifyMigrateJobSpec

- IsolateMigrateJob

- DestroyMigrateJob

- DescribeMigrateDBInstances

- CompleteMigrateJob

- PauseMigrateJob

- ContinueMigrateJob

- Data Sync APIs

- ModifySyncJobConfig

- CreateModifyCheckSyncJob

- DescribeModifyCheckSyncJobResult

- StartModifySyncJob

- DescribeSyncJobs

- CreateSyncJob

- ConfigureSyncJob

- CreateCheckSyncJob

- SkipSyncCheckItem

- DescribeCheckSyncJobResult

- StartSyncJob

- StopSyncJob

- ResumeSyncJob

- ResizeSyncJob

- RecoverSyncJob

- IsolateSyncJob

- DestroySyncJob

- PauseSyncJob

- ContinueSyncJob

- Data Consistency Check APIs

- Data Types

- Error Codes

- DTS API 2018-03-30

- SDK 文档

- 常见问题

- 错误处理(NewDTS)

- 错误处理(旧版)

- 相关协议

操作场景

数据同步到 Kafka 后,您可以通过0.11版本及以上的 Kafka 客户端 进行消费订阅数据,本文为您提供了 Java、Go、Python 语言的客户端消费 Demo 示例,方便您快速测试消费数据的流程,了解数据格式解析的方法。

注意事项

Demo 并不包含消费数据的用法演示,仅对数据做了打印处理,您需要在此基础上自行编写数据处理逻辑,您也可以使用其他语言的 Kafka 客户端消费并解析数据。

目标 Ckafka 中消息大小设置的上限需要大于源库表中单行数据的最大值,以便数据可以正常同步到目标端。

在同步指定库/表对象(非源实例全部),并且采用 Kafka 单分区的场景中,DTS 解析增量数据后,仅将同步对象的数据写入 Kafka Topic 中,其他非同步对象的数据会转成空事务写入 Kafka Topic,所以在消费数据时会出现空事务。空事务的 Begin/Commit 消息中保留了事务的 GTID 信息,可以保证 GTID 的连续性和完整性。同时,在 MySQL/TDSQL-C MySQL 的消费 Demo 中,多个空事务也做了压缩处理以减少消息数量。

为了保证数据可重入,DTS 同步到 Kafka 链路引入 Checkpoint 机制。消息写入 Kafka Topic 时,一般每10秒会插入一个 Checkpoint,用来标识数据同步的位点,在任务中断后再重启识别断点位置,实现断点续传。另外,消费端遇到 Checkpoint 消息会做一次 Kafka 消费位点提交,以便及时更新消费位点。

数据格式选择 JSON 时,如果您使用过或者熟悉开源订阅工具 Canal,可以选择将这里消费出来的 JSON 格式数据转换成 Canal 工具兼容的数据格式,再进行后续处理,我们的 Demo 中已经提供了相关支持,在启动 Demo 的参数中添加参数 trans2canal 即可实现。目前该功能仅限 Java 语言支持。

消费 Demo 下载

在配置同步任务中,您可以选择不同的数据格式,Avro 和 JSON。Avro 采用二进制格式,消费效率更高,JSON 采用轻量级的文本格式,更加简单易用。选择的数据格式不同,参考的 Demo 示例也不同。

如下提供的 Demo 示例,均已包含对应的 Avro/JSON 协议文件,无需另外下载。

Demo 中的逻辑讲解及关键参数说明,请参考 Demo 说明。

Java Demo 使用说明

编译环境:Maven 或者 Gradle 包管理工具,JDK8。用户可自行选择打包工具,如下以 Maven 为例进行介绍。

操作步骤:

1. 下载 Java Demo,然后解压该文件。

2. 进入解压后的目录,为方便使用,目录下分别放置了 Maven 模型文件、pom.xml 文件,用户根据需要选用。

使用 Maven 进行打包:mvn clean package。

3. 运行 Demo。

使用 Maven 打包后,进入目标文件夹 target,运行如下代码:

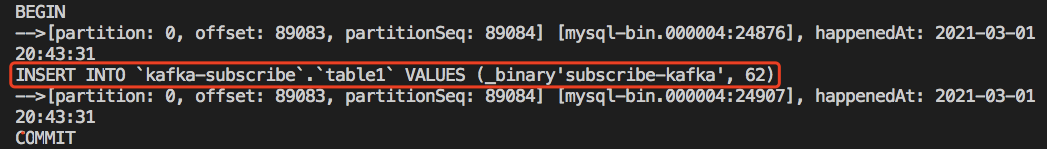

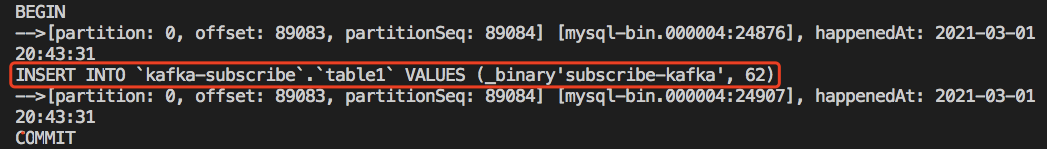

java -jar consumerDemo-avro-1.0-SNAPSHOT.jar --brokers xxx --topic xxx --group xxx --trans2sqlbroker 为 CKafka 的访问地址,topic 为同步任务中设置的 topic 名称,如果是多 topic 需要分别消费。这两个可通过数据同步 > 操作 > 查看获取。group为消费组名称,用户可提前在 Ckafka 中创建消费组,也可以在此处自定义输入。trans2sql 表示是否转换为 SQL 语句,java 代码中,携带该参数表示转换为 SQL 语句,不携带则不转换。trans2canal 表示是否转换为 Canal 格式打印出来,携带该参数表示转换为 Canal 格式,不携带则不转换。说明

携带 trans2sql 时,将使用

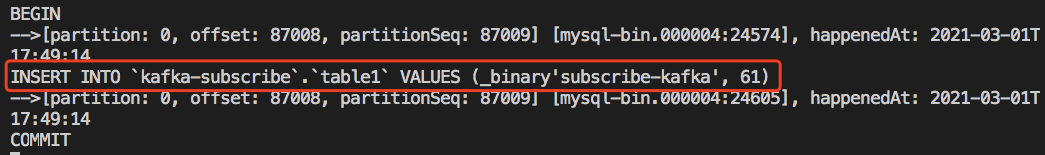

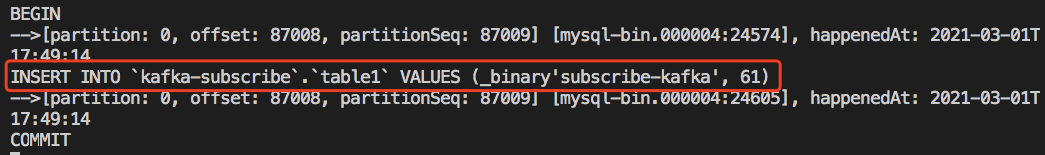

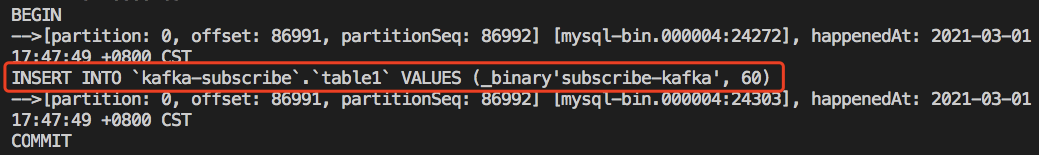

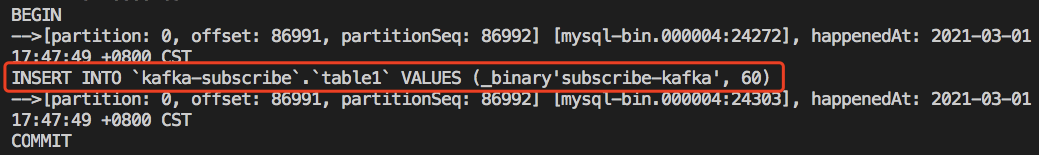

javax.xml.bind.DatatypeConverter.printHexBinary() 将 byte 值转成16进制,请使用 JDK1.8 版本及以上避免不兼容。如果不需要转 SQL,可以注释此处代码。4. 观察消费情况。

Golang Demo 使用说明

编译环境:Golang 1.12 及以上版本,配置好 Go Module 环境。

操作步骤:

1. 下载 Golang Demo,然后解压该文件。

2. 进入解压后的目录,运行

go build -o subscribe ./main/main.go,生成可执行文件 subscribe。3. 运行

./subscribe --brokers=xxx --topic=xxx --group=xxx --trans2sql=true。broker 为 CKafka 的访问地址,topic 为同步任务中设置的 topic 名称,如果是多 topic 需要分别消费。这两个可通过 数据同步>操作>查看 获取。group为消费组名称,用户可提前在 Ckafka 中创建消费组,也可以在此处自定义输入。trans2sql 表示是否转换为 SQL 语句。4. 观察消费情况。

Python3 Demo 使用说明

编译运行环境:安装 Python3,pip3(用于依赖包安装)。

使用 pip3 安装依赖包:

pip install flagpip install kafka-pythonpip install avro

操作步骤:

1. 下载 Python3 Demo ,然后解压该文件。

2. 运行

python main.py --brokers=xxx --topic=xxx --group=xxx --trans2sql=1。broker 为 CKafka 的访问地址,topic 为同步任务中设置的 topic 名称,如果是多 topic 需要分别消费。这两个可通过数据同步 > 操作 > 查看获取。group为消费组名称,用户可提前在 Ckafka 中创建消费组,也可以在此处自定义输入。trans2sql 表示是否转换为 SQL 语句。3. 观察消费情况。

是

是

否

否

本页内容是否解决了您的问题?