- 动态与公告

- 产品简介

- 购买指南

- 快速入门

- TKE 标准集群指南

- TKE 标准集群概述

- 购买 TKE 标准集群

- 容器服务高危操作

- 云上容器应用部署 Check List

- Kubernetes API 操作指引

- 开源组件

- 权限管理

- 集群管理

- 镜像

- Worker 节点介绍

- 普通节点管理

- 原生节点管理

- 超级节点管理

- 注册节点管理

- GPU 共享

- Kubernetes 对象管理

- 第三方节点管理

- Service 管理

- Ingress 管理

- 存储管理

- 应用与组件功能管理说明

- 组件管理

- 扩展组件概述

- 组件的生命周期管理

- CBS-CSI 说明

- UserGroupAccessControl 说明

- COS-CSI 说明

- CFS-CSI 说明

- P2P 说明

- OOMGuard 说明

- TCR 说明

- TCR Hosts Updater

- DNSAutoscaler 说明

- NodeProblemDetectorPlus 说明

- NodeLocalDNSCache 说明

- Network Policy 说明

- DynamicScheduler 说明

- DeScheduler 说明

- Nginx-ingress 说明

- HPC 说明

- tke-monitor-agent 说明

- GPU-Manager 说明

- CFSTURBO-CSI 说明

- tke-log-agent 说明

- 应用管理

- 应用市场

- 网络管理

- 集群运维

- 日志管理

- 备份中心

- 云原生监控

- 远程终端

- TKE Serverless 集群指南

- TKE 边缘集群指南

- TKE 注册集群指南

- TKE 容器实例指南

- 云原生服务指南

- 最佳实践

- 故障处理

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- Cluster APIs

- DescribeEncryptionStatus

- DisableEncryptionProtection

- EnableEncryptionProtection

- AcquireClusterAdminRole

- CreateClusterEndpoint

- CreateClusterEndpointVip

- DeleteCluster

- DeleteClusterEndpoint

- DeleteClusterEndpointVip

- DescribeAvailableClusterVersion

- DescribeClusterAuthenticationOptions

- DescribeClusterCommonNames

- DescribeClusterEndpointStatus

- DescribeClusterEndpointVipStatus

- DescribeClusterEndpoints

- DescribeClusterKubeconfig

- DescribeClusterLevelAttribute

- DescribeClusterLevelChangeRecords

- DescribeClusterSecurity

- DescribeClusterStatus

- DescribeClusters

- DescribeEdgeAvailableExtraArgs

- DescribeEdgeClusterExtraArgs

- DescribeResourceUsage

- DisableClusterDeletionProtection

- EnableClusterDeletionProtection

- GetClusterLevelPrice

- GetUpgradeInstanceProgress

- ModifyClusterAttribute

- ModifyClusterAuthenticationOptions

- ModifyClusterEndpointSP

- UpgradeClusterInstances

- CreateCluster

- UpdateClusterVersion

- UpdateClusterKubeconfig

- DescribeBackupStorageLocations

- DeleteBackupStorageLocation

- CreateBackupStorageLocation

- Add-on APIs

- Network APIs

- Node APIs

- Node Pool APIs

- TKE Edge Cluster APIs

- DescribeTKEEdgeScript

- DescribeTKEEdgeExternalKubeconfig

- DescribeTKEEdgeClusters

- DescribeTKEEdgeClusterStatus

- DescribeTKEEdgeClusterCredential

- DescribeEdgeClusterInstances

- DescribeEdgeCVMInstances

- DescribeECMInstances

- DescribeAvailableTKEEdgeVersion

- DeleteTKEEdgeCluster

- DeleteEdgeClusterInstances

- DeleteEdgeCVMInstances

- DeleteECMInstances

- CreateTKEEdgeCluster

- CreateECMInstances

- CheckEdgeClusterCIDR

- ForwardTKEEdgeApplicationRequestV3

- UninstallEdgeLogAgent

- InstallEdgeLogAgent

- DescribeEdgeLogSwitches

- CreateEdgeLogConfig

- CreateEdgeCVMInstances

- UpdateEdgeClusterVersion

- DescribeEdgeClusterUpgradeInfo

- Cloud Native Monitoring APIs

- Virtual node APIs

- Other APIs

- Scaling group APIs

- Data Types

- Error Codes

- API Mapping Guide

- TKE Insight

- TKE 调度

- 常见问题

- 服务协议

- 联系我们

- 购买渠道

- 词汇表

- 动态与公告

- 产品简介

- 购买指南

- 快速入门

- TKE 标准集群指南

- TKE 标准集群概述

- 购买 TKE 标准集群

- 容器服务高危操作

- 云上容器应用部署 Check List

- Kubernetes API 操作指引

- 开源组件

- 权限管理

- 集群管理

- 镜像

- Worker 节点介绍

- 普通节点管理

- 原生节点管理

- 超级节点管理

- 注册节点管理

- GPU 共享

- Kubernetes 对象管理

- 第三方节点管理

- Service 管理

- Ingress 管理

- 存储管理

- 应用与组件功能管理说明

- 组件管理

- 扩展组件概述

- 组件的生命周期管理

- CBS-CSI 说明

- UserGroupAccessControl 说明

- COS-CSI 说明

- CFS-CSI 说明

- P2P 说明

- OOMGuard 说明

- TCR 说明

- TCR Hosts Updater

- DNSAutoscaler 说明

- NodeProblemDetectorPlus 说明

- NodeLocalDNSCache 说明

- Network Policy 说明

- DynamicScheduler 说明

- DeScheduler 说明

- Nginx-ingress 说明

- HPC 说明

- tke-monitor-agent 说明

- GPU-Manager 说明

- CFSTURBO-CSI 说明

- tke-log-agent 说明

- 应用管理

- 应用市场

- 网络管理

- 集群运维

- 日志管理

- 备份中心

- 云原生监控

- 远程终端

- TKE Serverless 集群指南

- TKE 边缘集群指南

- TKE 注册集群指南

- TKE 容器实例指南

- 云原生服务指南

- 最佳实践

- 故障处理

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- Cluster APIs

- DescribeEncryptionStatus

- DisableEncryptionProtection

- EnableEncryptionProtection

- AcquireClusterAdminRole

- CreateClusterEndpoint

- CreateClusterEndpointVip

- DeleteCluster

- DeleteClusterEndpoint

- DeleteClusterEndpointVip

- DescribeAvailableClusterVersion

- DescribeClusterAuthenticationOptions

- DescribeClusterCommonNames

- DescribeClusterEndpointStatus

- DescribeClusterEndpointVipStatus

- DescribeClusterEndpoints

- DescribeClusterKubeconfig

- DescribeClusterLevelAttribute

- DescribeClusterLevelChangeRecords

- DescribeClusterSecurity

- DescribeClusterStatus

- DescribeClusters

- DescribeEdgeAvailableExtraArgs

- DescribeEdgeClusterExtraArgs

- DescribeResourceUsage

- DisableClusterDeletionProtection

- EnableClusterDeletionProtection

- GetClusterLevelPrice

- GetUpgradeInstanceProgress

- ModifyClusterAttribute

- ModifyClusterAuthenticationOptions

- ModifyClusterEndpointSP

- UpgradeClusterInstances

- CreateCluster

- UpdateClusterVersion

- UpdateClusterKubeconfig

- DescribeBackupStorageLocations

- DeleteBackupStorageLocation

- CreateBackupStorageLocation

- Add-on APIs

- Network APIs

- Node APIs

- Node Pool APIs

- TKE Edge Cluster APIs

- DescribeTKEEdgeScript

- DescribeTKEEdgeExternalKubeconfig

- DescribeTKEEdgeClusters

- DescribeTKEEdgeClusterStatus

- DescribeTKEEdgeClusterCredential

- DescribeEdgeClusterInstances

- DescribeEdgeCVMInstances

- DescribeECMInstances

- DescribeAvailableTKEEdgeVersion

- DeleteTKEEdgeCluster

- DeleteEdgeClusterInstances

- DeleteEdgeCVMInstances

- DeleteECMInstances

- CreateTKEEdgeCluster

- CreateECMInstances

- CheckEdgeClusterCIDR

- ForwardTKEEdgeApplicationRequestV3

- UninstallEdgeLogAgent

- InstallEdgeLogAgent

- DescribeEdgeLogSwitches

- CreateEdgeLogConfig

- CreateEdgeCVMInstances

- UpdateEdgeClusterVersion

- DescribeEdgeClusterUpgradeInfo

- Cloud Native Monitoring APIs

- Virtual node APIs

- Other APIs

- Scaling group APIs

- Data Types

- Error Codes

- API Mapping Guide

- TKE Insight

- TKE 调度

- 常见问题

- 服务协议

- 联系我们

- 购买渠道

- 词汇表

操作场景

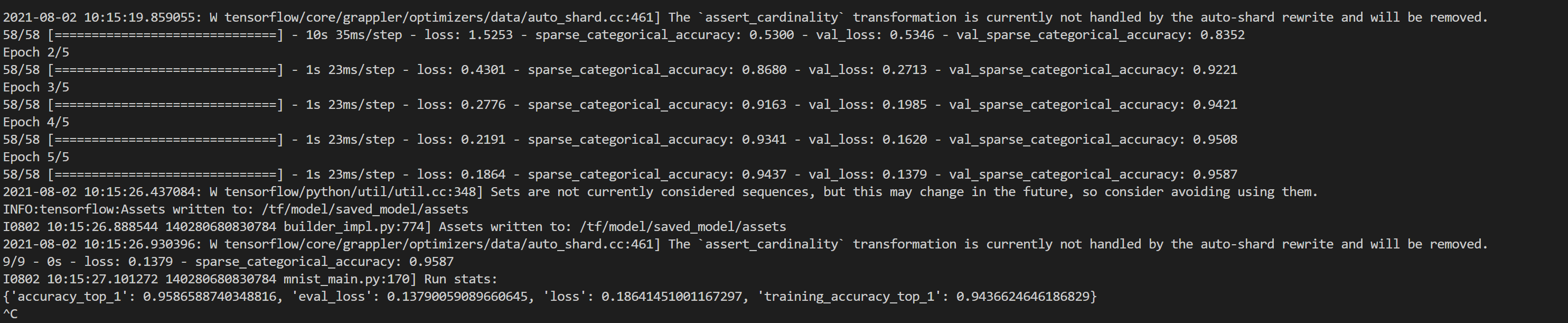

本系列文章将记录在 TKE Serverless 上部署深度学习的一系列实践,从直接部署 TensorFlow 到后续实现 Kubeflow 的部署,旨在提供一个较完整的容器深度学习实践方案。

前提条件

本文将在上一篇文档 构建深度学习容器镜像 基础上继续操作,利用自建集群,在 TKE Serverless 上运行深度学习任务。自建镜像已上传到镜像仓库中:ccr.ccs.tencentyun.com/carltk/tensorflow-model,无需重新构建,可以直接拉取使用。

操作步骤

创建 TKE Serverless 集群

请参见 创建集群 文档创建 TKE Serverless 集群。

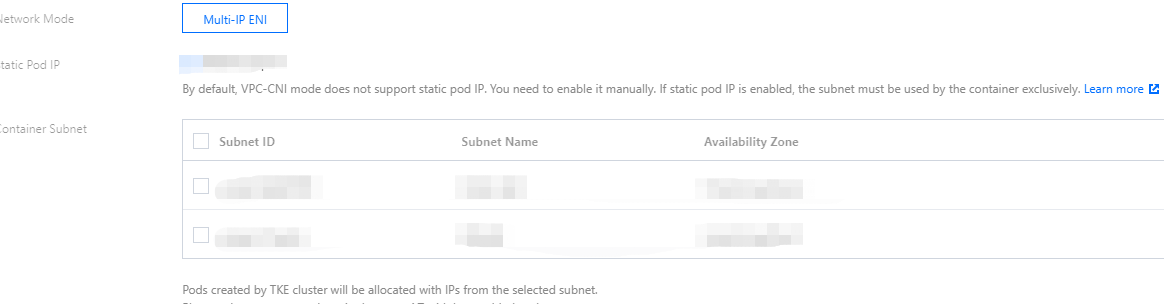

说明:由于需要运行 GPU 训练任务,在创建集群时,请注意选择的容器网络所在区的支持资源,选择支持 GPU 的可用区,如下图所示:

创建 CFS 文件系统(可选)

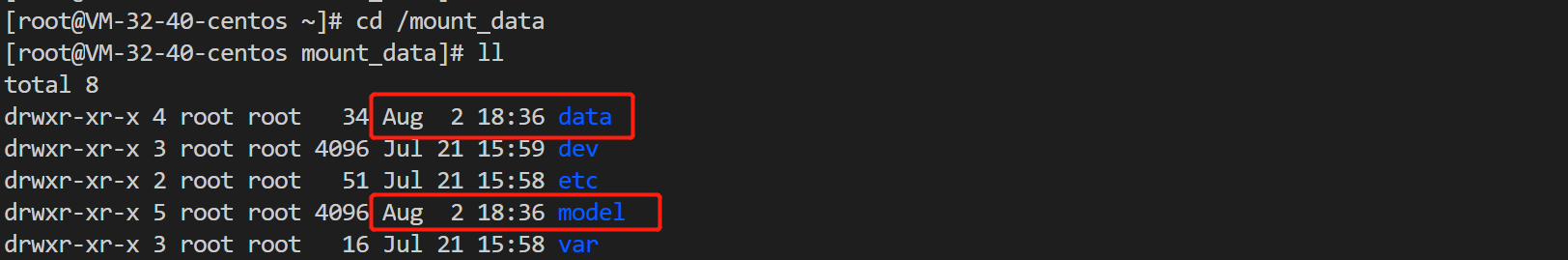

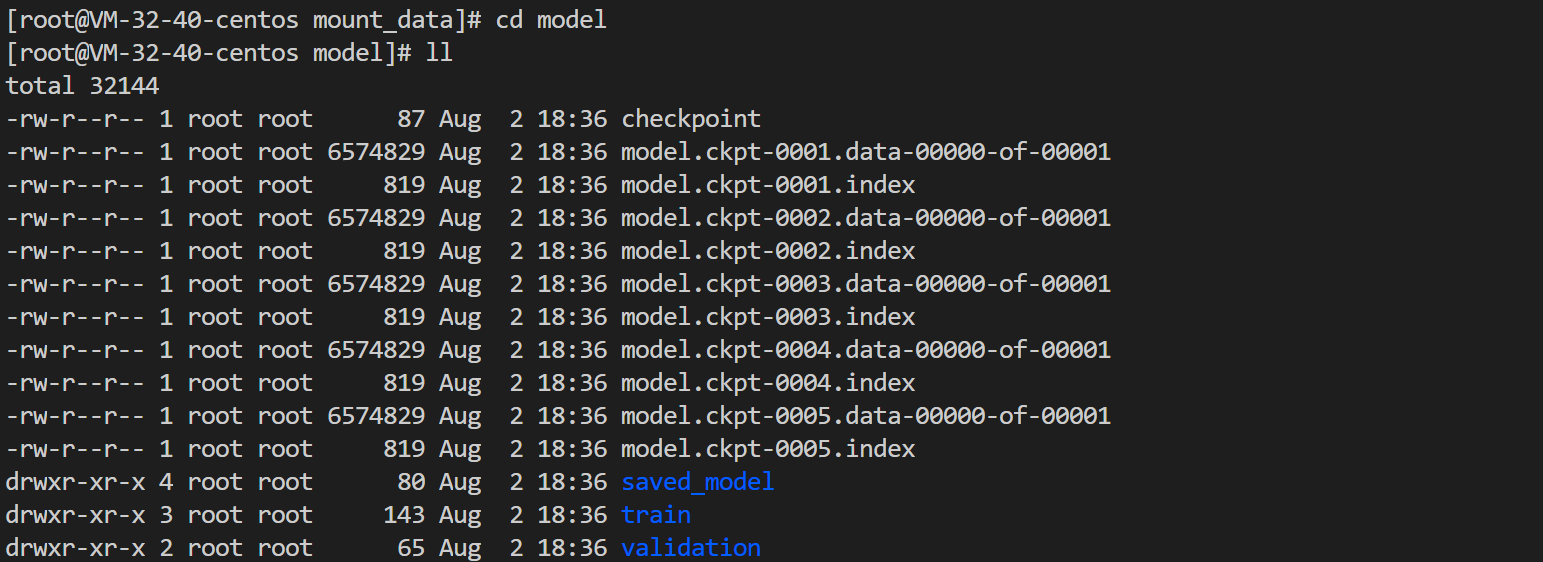

容器将在任务结束后,自动删除容器并且释放资源。因此为了实现对模型和数据的持久化存储,建议通过挂载外部存储的方式持久存储数据。目前支持 云硬盘 CBS、文件存储 CFS、对象存储 COS 等方式。

本文示例将利用 NFS 盘的方式,使用 CFS,实现于多读多写的持久化存储。

创建文件存储

- 登录 文件存储 CFS 控制台,进入“文件系统”页面。

- 单击创建,在弹出的“新建文件系统”页面中,选择文件系统类型,并单击下一步:详细设置。

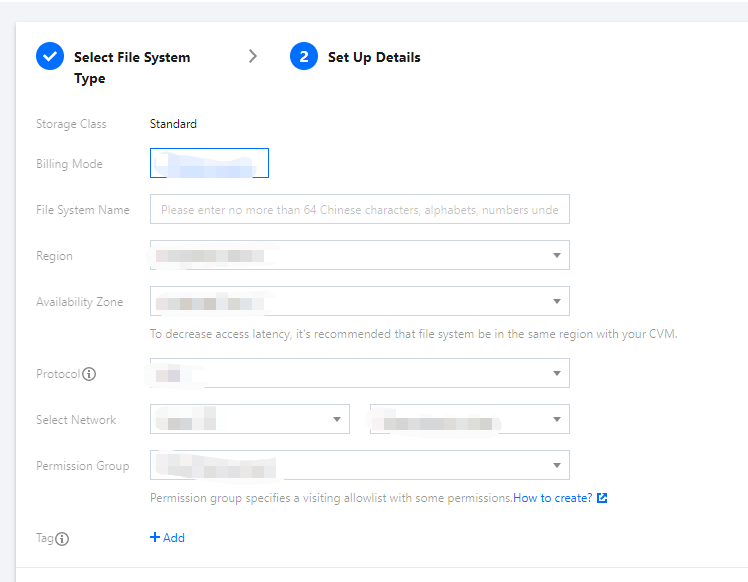

- 在“详细设置”页面进行相关配置,CFS 类型信息与配置细节可参见 创建文件系统及挂载点 文档。如下图所示:

注意:

注意:创建的 CFS 地域,需确保与集群在同一地域。

- 确认无误之后单击立即购买并完成付费即可创建文件存储。

获取文件系统挂载信息

- 在“文件系统”页面,单击需获取子目标路径的文件系统 ID,进入该文件系统详情页。

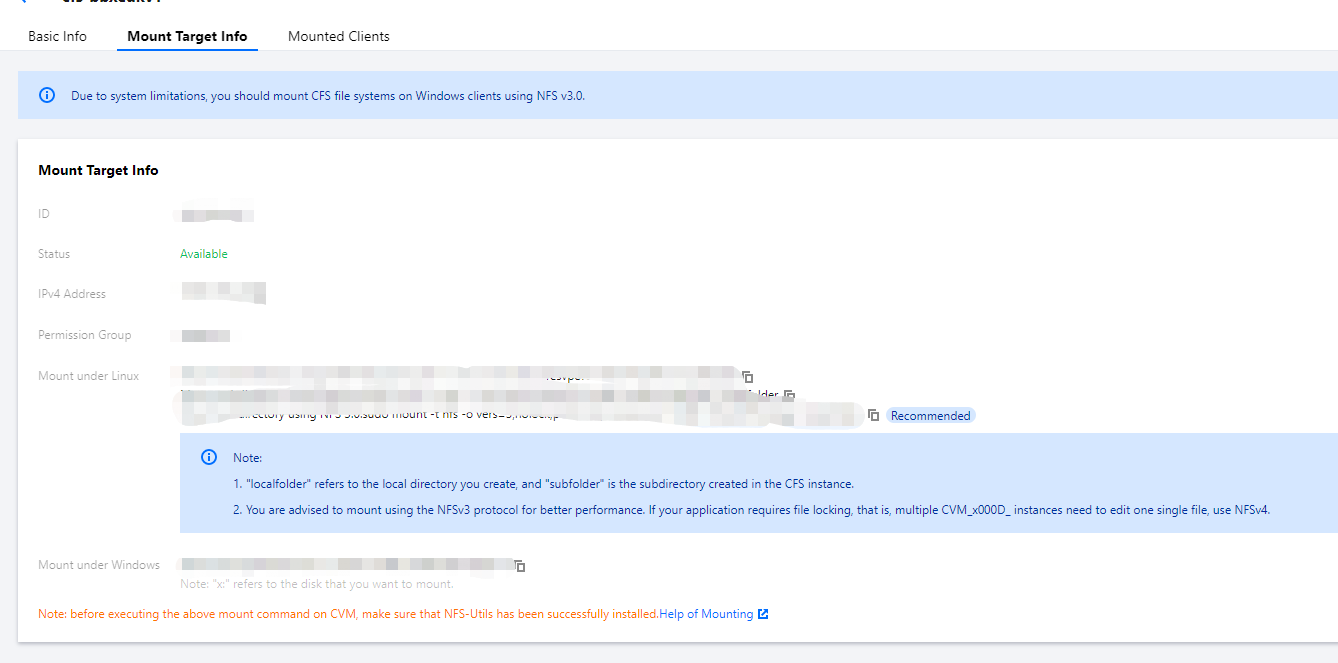

- 选择挂载点信息页签,从 “Linux下挂载” 获取该文件系统挂载信息。如下图所示:

说明:

说明:在挂载点详细中需要记住 IPv4 地址,IPv4 将作为 NFS 路径,后续配置挂载时需要,例如

10.0.0.161:/。

创建训练任务

本文任务以 MNIST 手写数字识别数据集,加两层 CNN 为例,相关示范镜像为上一章 自建镜像,如需自定义镜像,请参见 深度学习容器镜像构建 文档。以下提供两种创建任务的方式。

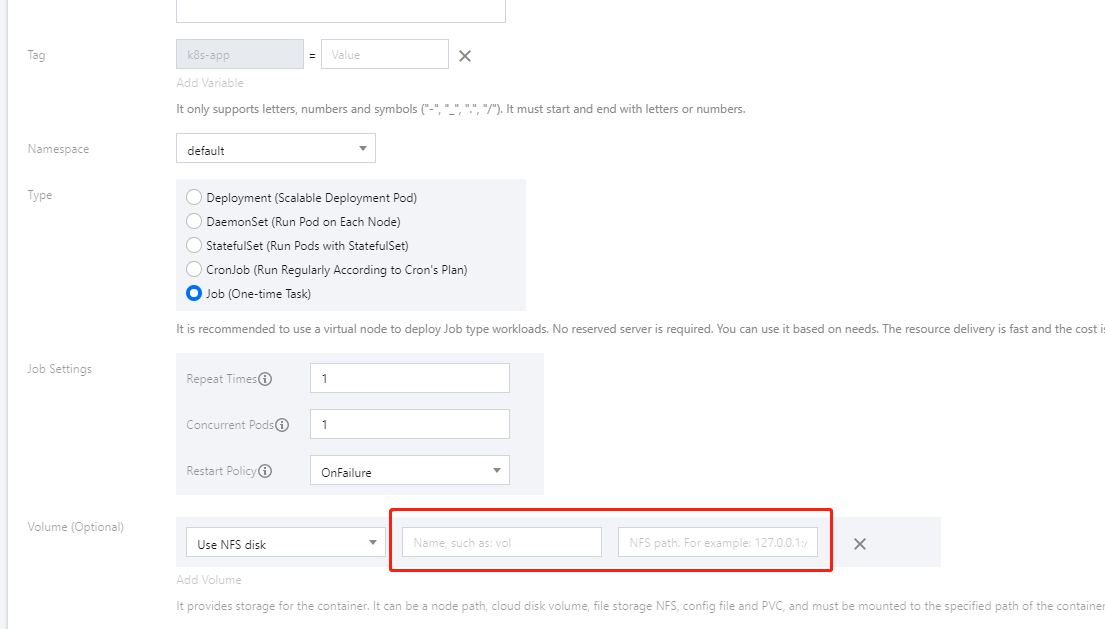

由于深度学习任务的性质,本文以部署 Job 节点为例。如何部署 Job 请参见 Job 管理 文档。以下提供控制台的部署范例:

- 在数据卷(选填)配置项中,选择 NFS 盘,并输入上述步骤创建的 CFS 名称和 IPv4地址。如下图所示:

- 在实例内容器中的挂载点配置项里,选择数据卷,并配置挂载点。注意

- 因为数据集可能需要联网下载,所以需要配置对集群的外网访问。详情请参见常见问题 公网访问相关。

- 选择 GPU 型号后,在填写 request 和 limit 时需要为容器分配符合 资源规格 的 CPU 和内存,实际填写并不严格要求精确到个位。在控制台中配置,也可以选择删除默认配置以留空,即为“不限制”,也会有对应的计费规格;更推荐这种做法。

- 容器运行命令 command 继承 Docker 的 CMD 字段,而 CMD 指令首选 exec 形式,不调用 shell 命令。这意味着不会发生正常的 shell 处理。因此命令需要 shell 形式运行,就需要在前面添加

"sh","-c"。在控制台输入多个命令和参数时,每个命令单独一行(以换行为准)。

查看运行结果

以下提供控制台和命令行两种方式查看运行结果:

在创建 Job 之后,默认进入 Job 管理页面。您也可以通过以下步骤进入 Job 管理页面:

- 登录容器服务控制台,选择左侧导航栏中的 集群 。

- 在弹性集群列表中,单击需要查看的事件集群 ID,进入集群管理页面。

- 选择工作负载 > Job,在 Job 列表中单击上述步骤创建的 Job。

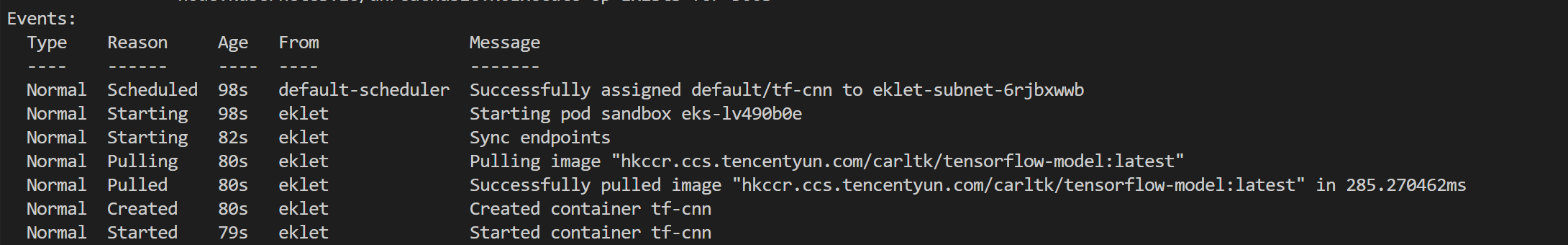

- 选择事件页签在查看事件

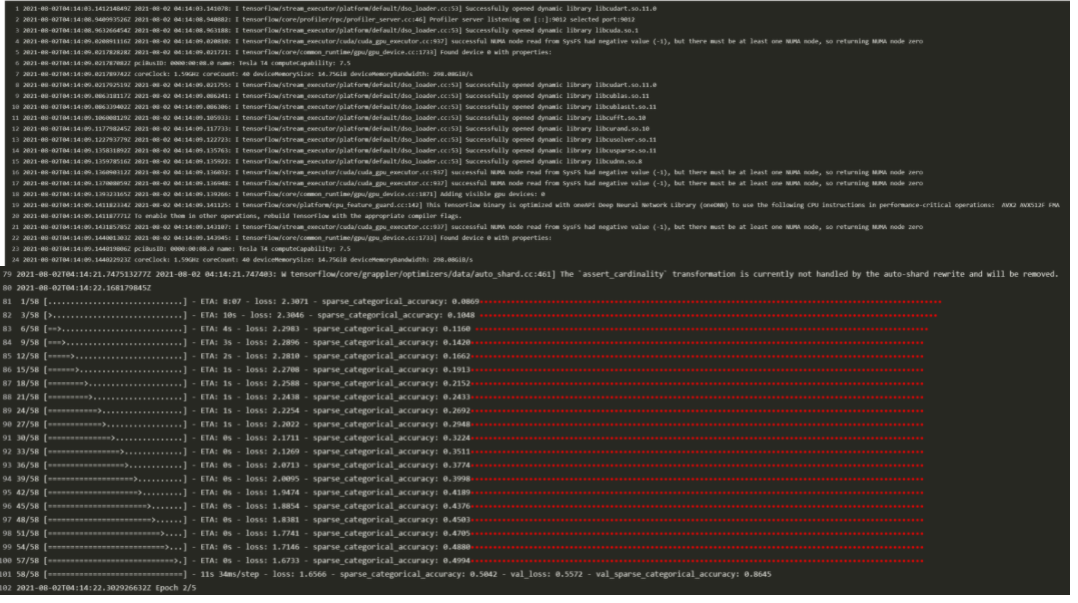

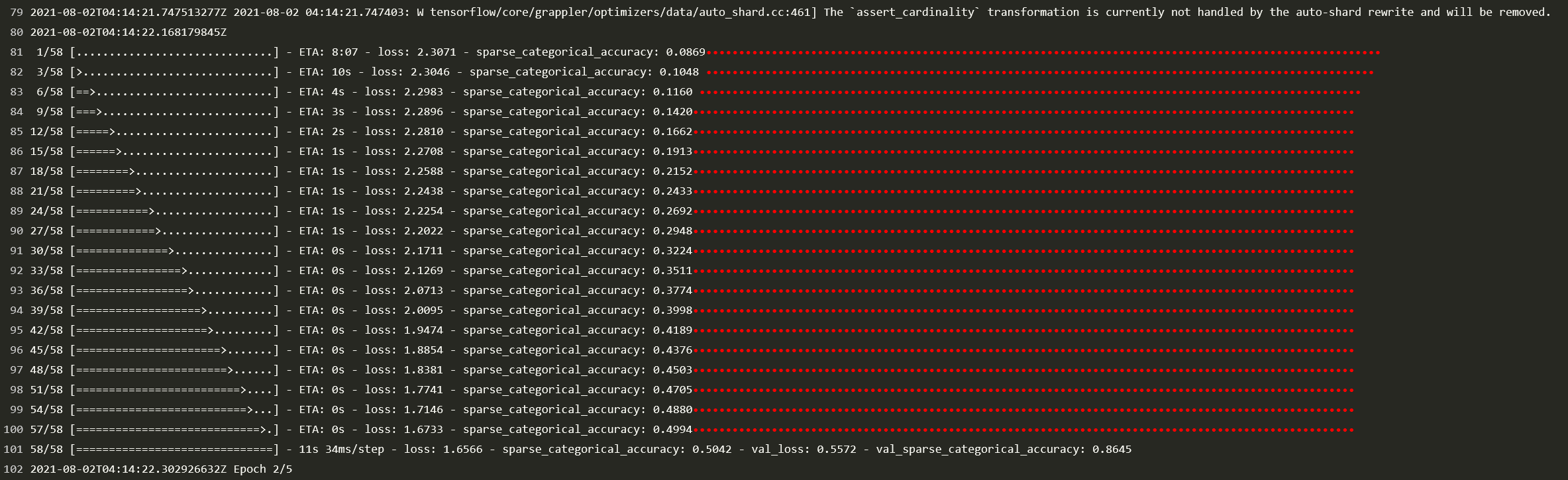

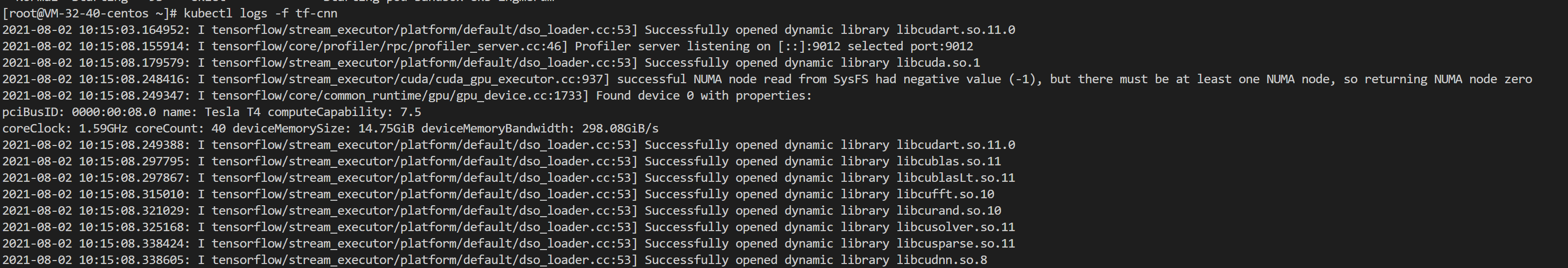

- 选择日志页签查看日志,如下图所示:

相关操作

在 TKE 上使用 GPU 部署深度学习任务

在 TKE 上部署和 TKE Serverless 的部署几乎没有区别。以 kubectl 通过 YAML 部署为例,有以下两点改动:

- 创建 TKE 节点时,选择带有 GPU 的节点。详情请参见 新建 GPU 云服务器 文档。

- 因为节点自带 GPU 资源,因此无需 Annotations 和 Resources。在实践操作汇总,您可以保留 Annotations,TKE 不会处理这部分。Resources 则建议注释掉,因为在某些情况下可能会导致不合理的资源需求。

常见问题

在进行本实践过程中遇到的问题,请参见 常见问题 文档进行排查解决。

是

是

否

否

本页内容是否解决了您的问题?